Hai Sahabat Brainy! Microsoft baru-baru ini merilis laporan yang memamerkan langkah-langkah mereka dalam mengembangkan platform AI yang bertanggung jawab sepanjang tahun lalu. Keren banget, kan? Yuk kita bahas!

Dalam Responsible AI Transparency Report yang fokus pada tahun 2023, Microsoft membanggakan pencapaiannya dalam meluncurkan produk AI yang aman. Laporan tahunan ini adalah salah satu komitmen yang dibuat Microsoft setelah menandatangani perjanjian sukarela dengan Gedung Putih pada Juli tahun lalu. Dalam perjanjian tersebut, Microsoft dan beberapa perusahaan lain berjanji untuk mengembangkan sistem AI yang bertanggung jawab dan mengutamakan keamanan.

Microsoft mengklaim telah menciptakan 30 alat AI yang bertanggung jawab dalam setahun terakhir. Mereka juga memperbesar tim AI yang bertanggung jawab dan mewajibkan tim yang membuat aplikasi AI generatif untuk mengukur dan memetakan risiko selama siklus pengembangan. Salah satu contohnya adalah menambahkan Content Credentials ke platform pembuat gambar mereka. Fitur ini akan menandai foto yang dihasilkan oleh model AI dengan watermark. Keren, ya?

Microsoft juga memberikan akses kepada pengguna Azure AI untuk menggunakan alat yang dapat mendeteksi konten bermasalah seperti ujaran kebencian, konten seksual, dan self-harm. Selain itu, Microsoft juga menyediakan alat untuk mengevaluasi risiko keamanan, termasuk metode deteksi jailbreak baru yang diperluas pada Maret tahun ini. Perluasan ini bertujuan untuk mendeteksi injeksi prompt tidak langsung di mana instruksi berbahaya dimasukkan ke dalam data yang dicerna oleh model AI.

Lebih lanjut, Microsoft memperluas upaya red-teaming mereka. Red-teaming adalah tim internal yang sengaja mencoba untuk melewati fitur keamanan dalam model AI mereka. Mereka juga mengembangkan aplikasi red-teaming untuk memungkinkan pengujian oleh pihak ketiga sebelum merilis model baru.

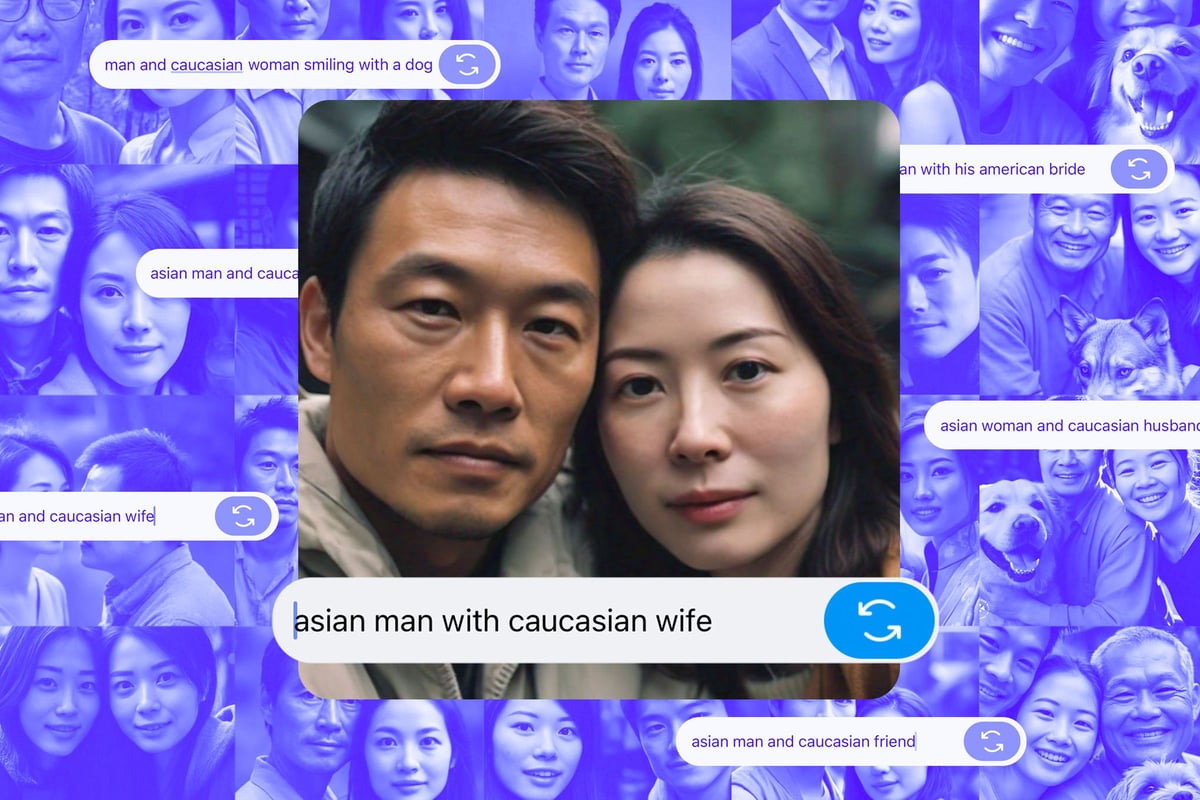

Namun, perjalanan Microsoft dalam mengembangkan AI yang bertanggung jawab tidak selalu mulus. Ketika Bing AI pertama kali diluncurkan pada Februari 2023, chatbot tersebut sering memberikan informasi yang salah. Bahkan, ada kejadian di mana Bing AI mengajarkan pengguna kata-kata kasar berbau rasis. Pada bulan Oktober, pengguna generator gambar Bing menemukan cara untuk menghasilkan foto karakter terkenal yang melakukan tindakan tidak pantas. Di bulan Januari, gambar palsu selebriti tanpa busana beredar di platform X. Gambar-gambar tersebut kabarnya berasal dari grup yang berbagi gambar yang dibuat dengan Microsoft Designer. Microsoft akhirnya menutup celah yang memungkinkan pembuatan gambar-gambar tersebut.

Natasha Crampton, kepala petugas AI yang bertanggung jawab di Microsoft, mengakui bahwa AI masih dalam tahap pengembangan dan begitu juga dengan AI yang bertanggung jawab. Ia menegaskan bahwa Microsoft akan terus berkomitmen untuk mengembangkan AI yang bertanggung jawab dan terus memperbaiki kekurangan yang ada.

Nah, Sahabat Brainy, itulah langkah-langkah yang dilakukan Microsoft dalam mengembangkan AI yang bertanggung jawab. Meskipun masih banyak tantangan yang harus dihadapi, komitmen Microsoft patut diapresiasi. Kita tunggu saja inovasi-inovasi selanjutnya dari Microsoft di dunia AI, ya!